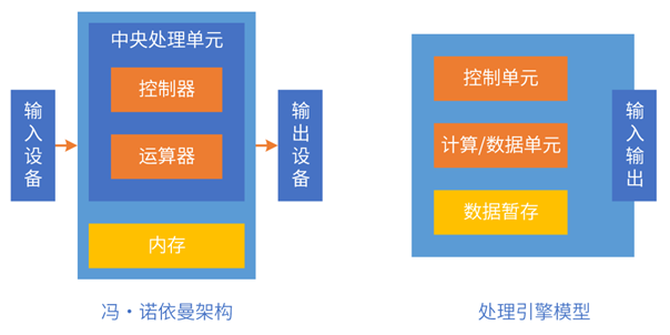

计算系统是由输入、计算和输出三部分组成,这个架构就是冯·诺依曼架构,非常的简单。现在行业内有很多号称打破冯·诺依曼架构的系统,但背后逻辑都是遵照冯·诺依曼架构的指导思想,严格来说不存在打破的说法。

然后是摩尔定律。基于CPU的摩尔定律真的已经到了极限,虽然说我们现在晶体管的提升也是慢慢到了一个极限,但是如果我们把摩尔定律当做一个KPI的话,那么对行业来说它又是一个非常重要的路线图,大家需要持续不断地提升性能,所以说对于计算性能的追求其实是永无止境的。

另外,再简单介绍下软件和硬件。首先,指令是软件和硬件之间的媒介,那么指令的复杂度决定了这个软硬件的解耦程度。ISA(指令集架构)之下,CPU、GPU等各种处理器是硬件;ISA之上,各种程序、数据集、文件等是软件。

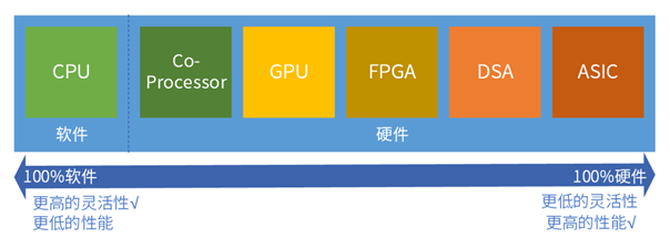

按照指令的复杂度,典型的处理器平台大致分为CPU、协处理器、GPU、FPGA、DSA、ASIC。从左往右,单位计算越来越复杂,性能越来越好,而灵活性越来越低。任务在CPU运行,则定义为软件运行;任务在协处理器、GPU、FPGA、DSA或ASIC运行,则定义为硬件加速运行。

什么是超异构计算?

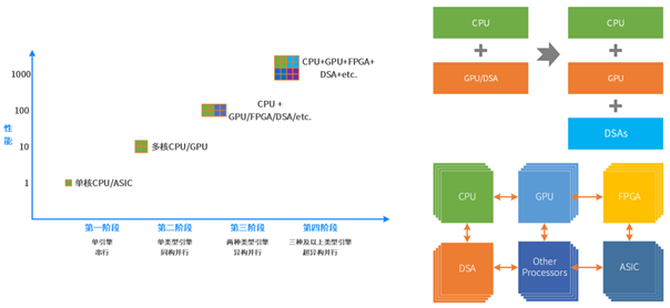

那么下一步,我们认为是持续往前走向超异构,为什么这件事情能够存在?

我们认为有几个原因使得超异构成为可能。那么首先一点就是超大规模的计算集群,其次是复杂宏系统,是由分层分块的组件(系统)组成。单服务器的宏系统复杂度,以及超大规模的云和边缘计算,使得“二八定律”在系统中普遍存在:把相对确定的任务沉淀到基础设施层,相对弹性的沉淀到弹性加速部分,其他继续放在CPU(CPU兜底)。

把更多的异构计算整合重构,各类型处理器间充分的、灵活的数据交互,形成超异构计算。未来就会有三个和三个以上类型的处理引擎,共同组成超异构并行。

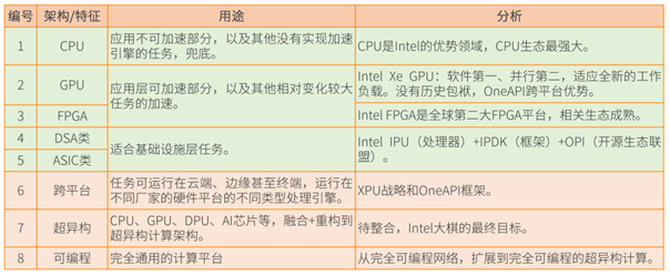

接下来我们介绍一些案例,首先是英特尔提出的超异构相关概念。当它提出来之后,并没有给出来完整的一个产品,反而是在超异构概念周边做了很多工作,最终我觉得会有很完整的东西出来。

2019年,英特尔提出超异构计算相关概念:XPU是架构组合,包括CPU、GPU、FPGA 和其他加速器;OneAPI是开源的跨平台编程框架,底层是不同的XPU处理器,通过OneAPI提供一致性编程接口,使得应用跨平台复用。

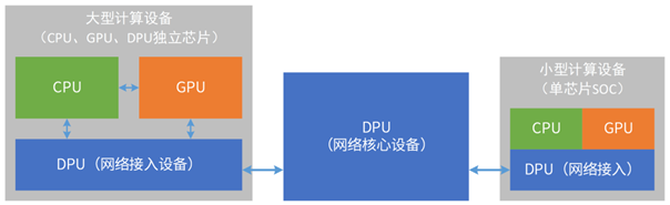

就是说我任何一个应用,我既可以在CPU运行,又可以在GPU运行,又可以在专用的ASIC上运行,通过OneAPI就可以跨不同的处理器平台,就可以自适应的去在平台上也有不同的计算资源。再说说英特尔的IPU,英特尔IPU跟现在市面上比较火爆的DPU是一个概念。

我们对英特尔的超异构计算进行一个总结,那它有CPU、GPU、FGPA,以及DSA和ASIC所组成的IPU,并且有了这个跨平台,也就是它所谓的XPU战略和oneAPI框架,最终把它整合成一个大芯片。

我们再来看英伟达Thor,这里很关键,为什么是数据中心架构?它所使用CPU、GPU、DPU跟数据中心里面用的架构一模一样,区别仅仅在于规格的不同,比方说数据中心可能有50个核,在终端可能用到30个核。

超级终端与传统终端最大的区别在于:支持虚拟化,支持多系统运行,支持微服务。手机、平板、个人电脑等传统AP是一个系统:部署好OS,上面运行各种应用,软件附属于硬件而存在。自动驾驶等超级终端,需要通过虚拟化将硬件切分成不同规格,供不同形态的多个系统运行,并且各个系统之间需要做到环境、应用、数据、性能、故障、安全等方面的隔离。

再然后看一下英伟达在数据中心的布局,NVIDIA Grace Hopper超级芯片是CPU+GPU,NVIDIA计划从Bluefield DPU四代起,把DPU和GPU两者集成单芯片。Chiplet技术逐渐成熟,未来趋势是CPU+GPU+DPU的超异构芯片。

为什么显而易见?这里面有英伟达自己的一个说法,我把这个进行了一个总结。首先,计算和网络不断融合:计算面临很多挑战,需要网络的协同;网络设备也是计算机,加入计算集群,成为计算的一部分。

数据在网络中流动,计算节点依靠数据流动来驱动计算。所有系统的本质是数据处理,那么所有的设备就都是DPU。以DPU为基础,不断融合CPU和GPU的功能,DPU会逐渐演化成数据中心统一的超异构处理器。

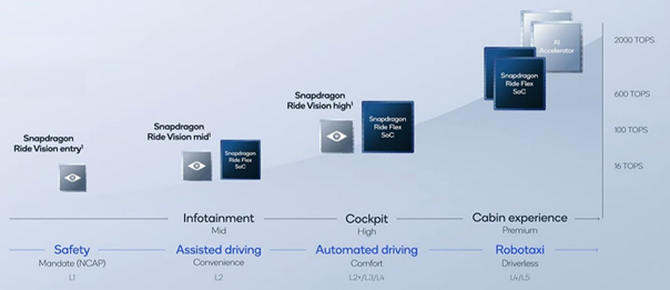

我们再来看高通。高通在手机端是很厉害的存在,往汽车域控制上发展也会有先天优势,但如果以最终的超级单芯片来讲,相对于英伟达还是有点劣势的。

趋势一:ARM成为多样性计算的重要选择

随着自动驾驶、云游戏、VR/AR等应用的兴起,以及物联网、移动应用、短视频、个人娱乐、人工智能的爆炸式增长,应用越来越多样化;应用的多样化驱动算力多样性发展。海量多样性的算力需求,加速了算力格局转换,ARM算力从嵌入式场景快速延伸至服务器场景。同时,在中国,服务器侧ARM生态已逐步成熟,并全面应用于国计民生行业。建议企业基于业务需求,识别适合ARM架构的业务场景,主动规划部署ARM架构服务器;有节奏地开展现有应用适配、迁移,并基于ARM架构,持续开发原生应用;通过全栈软硬件优化,充分释放多样算力,发挥极致性能。

趋势二:数字化走向深入,操作系统走向多样性算力和全场景的协同

操作系统作为计算产业中最基础的软件,承担着抽象底层硬件,向上层应用提供统一接口的核心功能,是计算产业的关键环节。面向多样性计算和海量应用场景,操作系统应支持多样算力和多种应用的协同,成为数字产业的可靠软件底座。建议规划部署支持数字基础设施多样算力的操作系统,使能全场景应用协同创新;分析应用迁移策略,制定应用迁移计划,完成应用高效迁移;加入开源操作系统社区,积极拥抱开源、回馈开源。

趋势三:数字经济发展引发算力需求爆炸式增长,人工智能算力增长是主要增量

当前,数字经济正在成为全球经济的主要增长点,算力作为数字经济时代新的生产力,是支撑数字经济发展的坚实基础,其中人工智能算力需求一直是指数级增长。同时,人工智能正日益快速渗透行业应用的核心场景。建议产业加速AI基础设施建设,让AI算力成为像水和电一样的公共资源;加速人工智能进入行业关键场景,使能行业智能化升级;产学研携手,共筑人工智能产业生态。

趋势四:大模型成为AI规模应用重要途径,科学计算正在进入科学智能新阶段

当前人工智能领域,“大算力+大数据”正在催生大模型的快速发展,孵化系列行业新应用。而科学计算是继大模型之后,AI发展的另一重要方向,科学计算正在从传统HPC进入科学智能新阶段。建议产学研各界汇聚大模型发展要素,使能大模型从规划到落地;打造科学智能基础平台、携手构筑科学智能生态,加速产业闭环。

趋势五:绿色高效成为算力基础设施建设的关键诉求

在双碳目标下,算力基础设施的建设更加注重能耗,需要通过从单领域创新走向系统级创新,实现绿色高效。建议建设模式从传统的部件堆叠逐步走向集群全栈一体化;散热方式逐步从传统风冷走向风液混合或全液冷;算力评估逐步从面向硬件的裸算力,走向面向业务的有效算力。

趋势六:算力网络将成为重要的算力供给方式

在“东数西算”“网络强国”等战略的牵引下,以人工智能计算中心、超算中心、一体化大数据中心等为代表的算力基础设施,成为国家新基建的重要组成,算力建设从分散化走向集约化。随着各地算力中心/算力基础设施陆续建成后,人工智能算力从算力中心,走向算力网络。建议各地加速算力基础设施建设;积极加入中国算力网,实现算力汇聚共享。

预计,到2030年,全球通用计算算力相 比2020年将增长10倍,AI算力将增长500倍。计算从通用计算进入通用计算+AI计算的多样性计算时代。