在云与AI加速融合的时代,底层的基础设施也在全面升级,以应对大参数、大数据和大算力挑战。从亚马逊云科技re:Invent 2024的最新发布来看,新型云基础设施不仅具有高性能、广分布和超大规模特点,更以横向和纵向全栈联动的创新方式,推动着企业的智能化变革。

众所周知,亚马逊云科技基础设施能力覆盖广泛(全球35个区域、111个可用区),凭借安全、可靠、灵活、可扩展等特点,成为数百万客户云业务创新的首选。走到今天,当生成式AI让人工智能技术的发展跑出“加速度”,基础设施的重要性再次凸显。数据显示,大模型参数量已达到400%的年均复合增长率,AI算力需求增长超过15万倍,远超“摩尔定律”。此种背景下,亚马逊云科技凭借顶 级云基础设施创新能力,成为智能算力基础设施的核心载体。

在2024re:Invent大会上,亚马逊云科技推出很多重磅创新发布,其广度和深度令人印象深刻,充分体现了全栈创新联动的能力。正如亚马逊云科技大中华区产品部总经理陈晓建所言,今天的亚马逊云科技已不只是一家全球云计算的开创者和引领者,更是企业构建和应用生成式AI的重要伙伴。亚马逊云科技不仅在云的核心服务层面持续创新,更在从芯片到模型,再到应用的每一个技术堆栈取得突破,让不同层级的创新相互赋能、协同进化。

单服务性能的纵向扩展

在人工智能巨量计算负载下,底层基础设施能力通常需要两个重要引擎:一个是更强大的服务器;另一个是构建更大规模、更高效率的服务器集群。只是,随着模型复杂性和数据量的增加,单纯扩大集群规模已无法有效缩短训练时间,同时实时推理的需求也超出了单实例架构的承载能力。为了解决单服务性能问题,亚马逊云科技对芯片、服务器等进行了一系列的联合创新。

▲Peter Desantis把Amazon Trainium2服务器搬上主舞台

作为云计算厂商中自研芯片的开创者,亚马逊云科技在芯片创新方面的表现尤为突出,早在十年前就开启了定制芯片之路。迄今为止,亚马逊云科技已推出了多个系列的自研芯片,包括:Amazon Nitro系统、通用处理器芯片Amazon Graviton、机器学习训练芯片Amazon Trainium和推理芯片Amazon Inferentia,不仅保持了稳定的更新频率,而且每次更新均是两位数以上的性价比提升。

面对人工智能基础设施创新场景,亚马逊云科技推出了专门的芯片设计。第一个举措是,专为AI背后常见的矩阵或张量操作而设计。在Amazon Tranium的最新升级中,通过脉动阵列(Systolic Arrays)的硬件架构,可以在计算步骤之间直接将结果从一个计算单元传递到下一个计算单元,以减少内存带宽压力,避免内存访问,极大地优化了计算资源。另一个重要部署是,提升计算密集型工作负载的性能。通过Neuron内核接口Neuron Kernel Interface(NKI),开发者可以直接访问裸机的Trainium芯片,从计算内核层面最大限度地提升性能。

在大模型工作负载下,只有芯片还不够,还需要更大规模、更优性能和更高性价比的服务器创新。从服务器创新层面来看,Amazon EC2 Trn2服务器和Amazon EC2 Trn2 UltraServers超级服务器都是为AI负载而设计,并提供快速扩展能力。对比通用负载,智能工作负载的服务器规模要求更大,Amazon EC2 Trn2 UltraServers拥有64个Tranium2芯片协同工作,提供比任何当前EC2 AI服务器高五倍的计算能力和十倍的内存。用亚马逊云科技高级副总裁Peter DeSantis的话总结:“如果你要构建一个万亿参数的AI模型,这就是你需要的那种服务器。”

把大型模型引入企业的实际生产环境,最大的挑战是性能和性价比。为了提供更好的性能,亚马逊云科技通过Amazon Bedrock新推出了延迟优化选项,用户可以在各种领先的模型上获得最 佳推理性能,比如:Llama405B在预填充和标记生成的总响应时间上拥有更卓越表现;延迟优化的Claude3.5比标准Claude3.5快60%。在性价比方面,与当前基于GPU的EC2 P5e和P5en实例相比,Amazon EC2 Trn2实例的性价比提升30-40%。

最后,在重要的机器学习场景,亚马逊云科技带来了里程碑式创新。借助Amazon Neuron SDK,包括编译器、运行时库和工具等服务,开发者可以优化模型,在Trainium上获得更好的运行体验。Amazon Neuron SDK与JAX和PyTorch等热门框架原生集成,使客户在Trainium上使用现有代码和工作流时只需进行少量代码修改。随着行业内广泛的开源协作,以及Trainium2的推出,预计JAX在机器学习社区的应用将显著增加,这将成为整个机器学习生态系统的重要创新。

网络架构层面的横向延伸

在AI集群的世界里,时间就是金钱。对于极其苛刻的人工智能工作负载场景来说,再强大的算力也不够。为了提供更极致的计算力,亚马逊云科技从专有网络层面进行了横向延伸。

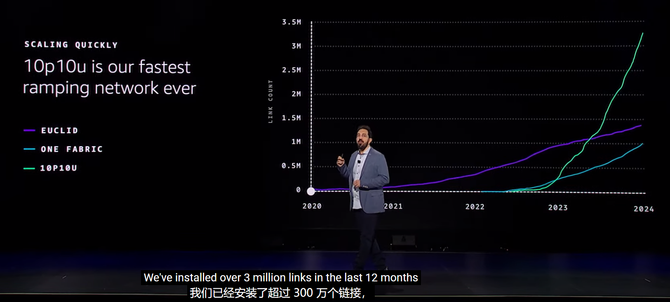

▲10p10u成为亚马逊云科技有史以来扩展最快的网络

首先,采用可扩展网络架构。其中,10p10u的推出可以说新型AI网络架构的代表,在过去的12个月里,10p10u的安装超过300万条链路。10p10u是带宽达10Pb/s,延迟低于10ms的网络架构。重要创新点在于:1)将16根单独光线电缆组成一个单一的连接器,从而将复杂的组装在工厂完成,能够加快54%的安装到机架上的时间;2)提供定制的光纤插头和光纤电缆,能够在机架到达数据中心前进行全面的测试和验证网络连接,从而消除调试布线的时间,同时还提供保护密封,防止灰尘颗粒进入光纤接口。

其次,采用SIDR(Scalable, Intent Driven Routing)全新网络路由协议。该协议是专为解决AI网络中光链路故障频发、路由更新缓慢的问题而设计,兼具中央控制和优化及分布式的速度和弹性。最大的优势是,结合了集中规划的全局控制和去中心化的快速响应,中央规划器提前生成“网络意图”并推送到各交换机,当链路故障发生时,交换机可自主决策,避免依赖中央控制器。相比传统的BGP、OSPF等协议,SIDR在AWS的10p10u网络中能在不到1秒内恢复网络,速度比传统方法快10倍,显著提升了分布式AI训练中的可靠性和实时性,确保网络在故障发生时也能保持高效运行。

整个数据中心的全面优化

随着生成式AI的日益普及以及客户对GPU容量需求的不断增长,亚马逊云科技还在整个数据中心层面不断优化,以支持更高的功率密度需求。

在高密度负载方面,亚马逊云科技通过优化数据中心的机架布局,最大化提升电力使用效率。更难能可贵的是,亚马逊云科技是通过软件实现了这一点,该软件由数据和生成式AI驱动,能够精确预测服务器的最 佳部署方式。亚马逊云科技在电力传输系统上和工程突破,使得亚马逊云科技在未来两年内能够将机架功率密度提升6倍,并有望在未来进一步提升3倍。

另外,新型AI服务器对液体冷却有更高要求。亚马逊云科技开发了一项先进的机械冷却解决方案——在其新建及现有数据中心配置“液体到芯片”的冷却系统。这一更新将无缝集成空气和液体冷却功能,用于支持包括如Amazon Trainium2的强大AI芯片系列、NVIDIA GB200 NVL72等机架级AI超级计算解决方案,以及亚马逊云科技网络交换机和存储服务器。无论客户运行传统工作负载还是AI模型,这种灵活的多模式冷却设计确保了亚马逊云科技都能以最低的成本为客户提供最 佳性能和效率。

除了冷却、机架设计,控制系统升级也是数据中心优化的重点。亚马逊新推出的控制系统已应用于电气与机械设备中,实现了监控、报警和运营流程的标准化。例如,利用亚马逊云科技内部构建的遥测工具以及使用最新技术,能够提供实时诊断和故障排除服务,确保客户保持最 佳运行状态。此外,亚马逊云科技在提升控制系统冗余度的同时,也简化了系统复杂性,使得基础设施可用性设计达到99.9999%。

写在最后

当云计算不仅支持着传统通用计算应用的数字化转型,还要支持以AI大模型为代表的智能计算应用,对底层服务来说无疑提出了更高的要求。此种背景下,云基础设施也要与时俱进,通过全栈联动的大规模创新,才能真正满足客户的发展需求。而以亚马逊云科技为代表的企业,正在从硬件、网络等不同层面协同进化,加速推动云与AI融合步伐,实现前沿技术的价值释放,助力各行各业重塑未来。