DeepSeek、元宝、豆包、通义、文心一言……大模型的百花齐放,不仅带来了选择的多样性,也让AI开发的变得复杂,有没有一种更简单的方式,只通过一个入口就能接入所有大模型?当很多人还在AI集成工具层面上下求索时,一个叫做MCP的大模型协议火遍全网。那么,到底什么是MCP?为什么一个小小的协议会让AI工具集走向划时代的效应?这要从MCP的出处开始扒起!

MCP带来AI工具集成进化的一大步

什么是MCP?

从定义来看,MCP(Model Context Protocol模型上下文协议)诞生于2024年11月底,是由 Anthropic 推出的一种开放标准,旨在统一大型语言模型(LLM)与外部数据源和工具之间的通信协议。MCP 的主要目的在于解决当前 AI 模型因数据孤岛限制而无法充分发挥潜力的难题,MCP 使得 AI 应用能够安全地访问和操作本地及远程数据,为 AI 应用提供了连接万物的接口。

可以说,大模型是MCP 成长的沃土,主要目的是为了解决多AI客户端带来的麻烦。举个栗子,在过去,为了让大模型等AI应用使用我们的数据,要么复制粘贴,要么上传下载,非常麻烦。即使是最强大模型也会受到数据隔离的限制,形成信息孤岛,要做出更强大的模型,每个新数据源都需要自己重新定制实现,使真正互联的系统难以扩展,存在很多的局限性。

现在,MCP 可以直接在 AI 与数据(包括本地数据和互联网数据)之间架起一座桥梁,只要大家都遵循这套协议,就能实现“万物互联”。

有了MCP,所有数据和文件系统、开发工具、Web浏览器和自动化生产工具,包括通信、社区生态能力等全部集成,能实现更强大的协作工作能力,其价值远不可估量。比如:Manus能让模型执行很多操作,本质上使用的也是类似的协议。

新标准背后的工作原理

MCP赋予了大模型的超级能力,一次构建就可以让AI与工作流深度集成,没想到千帆过境的大模型之争,竟然被一个标准协议统一。

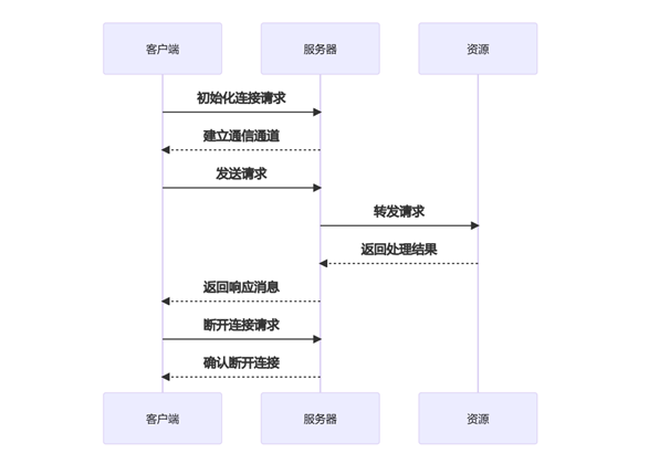

追寻背后原理,MCP协议采用了一种独特的架构设计,将LLM与资源之间的通信划分为三个主要部分:客户端、服务器和资源。

客户端负责发送请求给 MCP 服务器,服务器则将这些请求转发给相应的资源。这种分层的设计使得 MCP 协议能够更好地控制访问权限,确保只有经过授权的用户才能访问特定的资源。

MCP 的基本工作流程:

初始化连接:客户端向服务器发送连接请求,建立通信通道。

发送请求:客户端根据需求构建请求消息,并发送给服务器。

处理请求:服务器接收到请求后,解析请求内容,执行相应的操作(如查询数据库、读取文件等)。

返回结果:服务器将处理结果封装成响应消息,发送回客户端。

断开连接:任务完成后,客户端可以主动关闭连接或等待服务器超时关闭。

主要优势如下:

让开发变得更简单:一次编写,多次集成,无需为每个新集成重写定制代码 。

灵活性更强:切换AI模型或工具时,不需要复杂的重新配置 。

可满足实时响应需求:MCP连接保持活跃状态,支持实时上下文更新和交互 。

内置的安全和合规性:内置访问控制机制和标准化的安全实践 。

可扩展性增强:随着AI生态系统的扩展,只需连接新的MCP服务器即可轻松添加新功能。

打个比方来说,API就像是不同的门,其中每扇门都有自己独特的钥匙和使用规则,该协议打破了传统API的局限,为AI助手和外部系统打造了一套通用的标准语言。对于开发者,它带来了降低 90% 的适配成本;对于用户,它是让AI更懂自己的魔法。MCP的价值,在于让AI真正落地到现实场景,让技术普惠不再停留在口号。

结语

如果说 HTTP 协议让信息孤岛连成互联网,MCP的进化在于让 AI 模型从简单的对话应用专为全能助手。当然,一个协议是否能真的成为标准,还要看后面的发展生态,但从MCP这波热度来看,堪称是智能体生态的一次标准化革命。