今天,大模型领域迎来新变局!OpenAI在深夜宣布,重磅开源两款推理模型GPT-OSS-120B和20B。这是继2019年GPT-2 之后,OpenAI 首次开放模型权重,打破了“闭源王者”一直以来的沉默,全面拥抱开源。

“闭源王者”走向开源

GPT-OSS系列模型的最新发布,震惊业界!很多科技媒体用“炸裂”、“核弹”来形容OpenAI回归开源带来的影响!

gpt-oss-120b:性能强大,可以在单个Nvidia GPU上运行。

gpt-oss-20b:是轻量版,适用于 16GB内存的消费级笔记本电脑。

GPT-OSS系列模型采用了类似于O4-mini的训练流程进行后训练,同时与OpenAI O系列推理模型在API中的实现方式相同,可支持低、中、高三种推理强度。

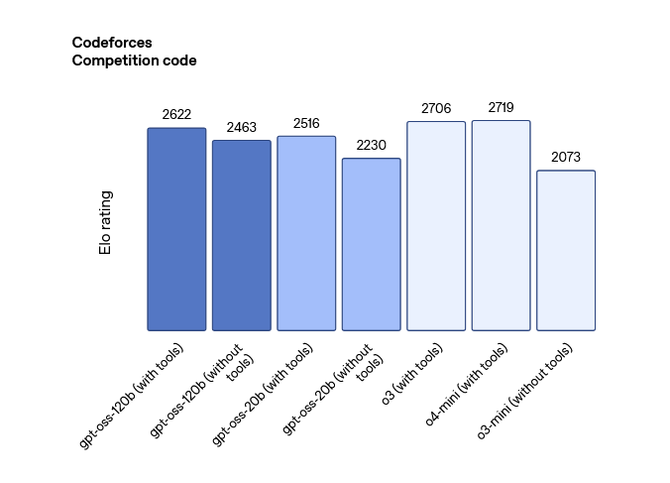

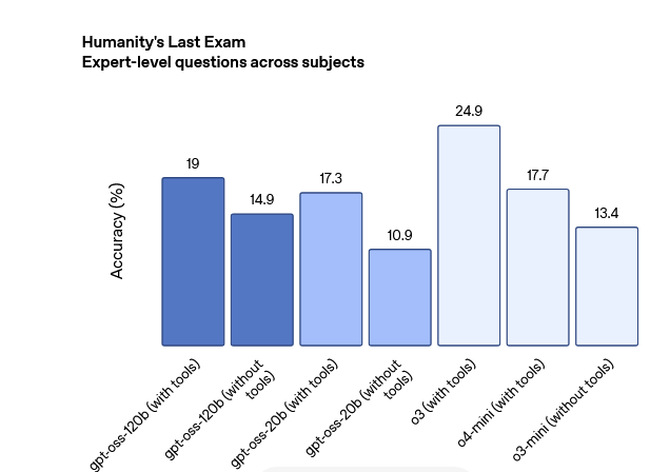

在大模型基准测试评估过程中,gpt-oss-120b在竞赛编程、通用问题解决以及工具调用方便表现优于OpenAI O3-mini,性能上与OpenAI O4-mini持平甚至实现了超越。

轻量版gpt-oss-20b模型与O3-mini性能相当,在部分基准测试指标上前者超越了后者。

两款模型均基于 Transformer 架构,并采用专家混合(Mixture of Experts, MoE)技术,有效减少处理输入时所需的激活参数数量,从而提升推理效率。

其中,gpt-oss-120b 每处理一个 token 激活约 51 亿(5.1B)参数,而更轻量的 gpt-oss-20b 则激活约 36 亿(3.6B)参数。

两者的总参数量分别为 1170 亿(117B)和 210 亿(21B),在性能与资源消耗之间实现了良好平衡。

OpenAI的首席执行官山姆·奥尔特曼在社交媒体上表示:“GPT-OSS的发布,是一个重大突破,它是目前世界上最 先进的开放权重推理模型,具备与o4-mini相媲美的强大实际应用性能,其轻量版本能在个人电脑乃至手机等本地设备上运行。”

虽然,GPT-OSS系列模型并非传统意义上的开源——训练数据并未包含在内——但它们的代码和模型参数是开放的,这意味着任何人都可以使用、调整并在此基础上构建新的应用。

· GitHub 地址:https://github.com/openai/gpt-oss

· hugging face 地址:https://huggingface.co/openai/gpt-oss-20b

· hugging face 地址:https://huggingface.co/openai/gpt-oss-120b

· 博客地址:https://openai.com/index/introducing-gpt-oss/

开放模型权重背后

OpenAI的开源模型与传统的开源模式不同,不像Meta的LLaMA这样的模型,做到全部开源,用户不能访问其训练数据。

这可能是OpenAI在LLM开源和闭源之间找到的更中立的做法。开放权重,是因为OpenAI看到了开源带来的进步,尤其是看到了以DeepSeek为代表的开源模型在世界舞台上取得的进步,让其感受到竞争带来的压力。

同时,特朗普政府也在从政策角度支持美国科技公司采用更多的开源技术,以达成与“美国价值观”一致的创新能力,在人工智能领域实现战略地位的领先。

无论背后是何种动机,这次的开源举措不仅对OpenAI公司自身发展,起到推动作用;对于整个AI生态的健康发展,也是一个巨大的进步。

相信,随着企业用例的增长,对于灵活性有更高需求的企业将会成为高频用户。至此,OpenAI将凭借开源优势获得更多用户的支持,无论是初创公司还是大型企业,都能满足他们的需求。

此外,关于OpenAI是否会独立运营的问题,目前看来可能性非常大。Altman正积极探索创建自己的数据中心,除了从封闭走向开源,他们也会从更多角度增强其市场竞争力和服务范围。

总之,这次OpenAI的开源决策反映了其适应市场变化的决心,同时也预示着全球大模型正走向一个更加开放和多元化的新生态。